Apple’ın geçtiğimiz günlerde Çocuk İstismarını Önleme Kiti’ni açıklaması ile beraber teknoloji dünyasında yeni bir tartışma ortaya çıktı.

Whatsapp CEO’su Will Cathcart, Apple‘ın yazılım önerisinin özel hayatın gizliliğinin açık bir ihlali olduğunu ve dünyaya endişe verici bir şey sunulduğunu söylerken Whatsapp’ın bu sistemi kabul etmeyeceğini de ekledi.

Fakat bu tartışmanın yanı sıra Dünya Sağlık Örgütü’nün 2020 yılında paylaştığı rapora göre, 2-17 yaşları arasındaki 1 milyara yakın çocuk 2019 yılında fiziksel, cinsel ya da duygusal şiddete maruz bırakıldı. World Vision’ın verilerine göre ise, her yıl dünyada 1 milyar 700 milyon çocuğun istismara uğradığı rapor ediliyor.

Çocuk istismarının görünür şekilde arttığı bu dönemde Apple’ın Çocuk İstismarını Önleme Kiti (CSAM) kullanıcılara neler sunuyor ;

Çocuk Cinsel İstismar Önleme Kiti (CSAM) ile Apple, iletişim araçlarını kullanarak çocukları işe alan ve sömüren kişilerden , bu kit ile çocukların korunmasına yardımcı olmayı ve kişileri güçlendiren ve hayatlarını zenginleştiren aynı zamanda onların güvende olmalarına yardımcı olan bir teknoloji yaratmayı amaçlıyor.

3 alanda geliştirilen çocuk cinsel istismarını önlemeye yönelik kit, ebeveynlere çocukların çevrimiçi hareketlerinde onlara yardımcı olmak ve onları bilinçlendirmek konusunda rol oynayacak.

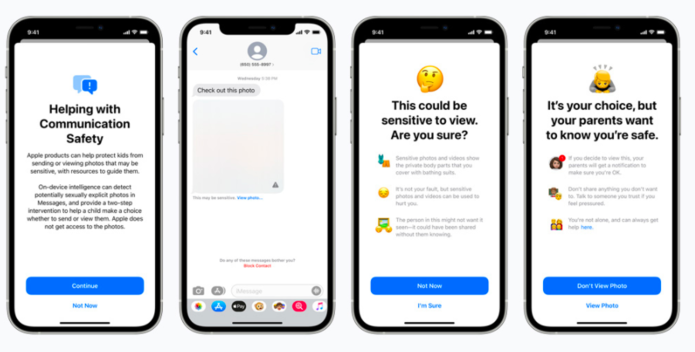

Mesajlar uygulaması, özel iletişimleri Apple tarafından okunamaz halde tutarken hassas içerik hakkında uyarmak için cihazdaki makine öğrenmesini kullanacak.

Mesajlar uygulaması tarafından çocuğun telefonuna cinsel içerikler geldiğinde fotoğraf bulanıklaştırılacak çocuk uyarılacak, konu ile ilgili yardımcı kaynaklar sunulacak ve bu fotoğrafı görmek istemezse sorun olmayacağına dair güvence verilecek . Ek bir önlem olarak, çocuğa, güvende olduklarından emin olmak için, görürlerse ebeveynlerinin bir mesaj alacağı da söylenebilecek. Bir çocuk cinsel içerikli fotoğraflar göndermeye çalışırsa benzer korumalar olacak. Fotoğraf gönderilmeden önce çocuk uyarılacak ve eğer çocuk fotoğrafı göndermeyi seçerse ebeveynleri bir mesaj alabilecek.

iOS ve iPadOS, kullanıcı gizliliği için tasarım yaparken Çocuk Cinsel İstismarını Önleme Kiti (CSAM), cinsel istismarın çevrimiçi yayılmasını sınırlamaya yardımcı olmak için yeni şifreleme uygulamaları kullanacak. CSAM algılaması, Apple‘ın iCloud Fotoğrafları’ndaki Çocuk Cinsel İstismarını Önleme Kiti (CSAM) koleksiyonları hakkında kolluk kuvvetlerine değerli bilgiler sağlamasına yardımcı olacaktır.

Son olarak, Siri ve Arama güncellemeleri, ebeveynlere ve çocuklara genişletilmiş bilgi sağlayacak ve güvenli olmayan durumlarla karşılaştıklarında yardımcı olacak. Siri ve Arama motoru , kullanıcılar CSAM ile ilgili konuları aramaya çalıştığında da müdahale edecek.

“neuralMatch” adlı uygulama sayesinde Apple, iPhone kullanıcılarının cihazlarında çocuk pornosu ve benzeri metaryeller tespit ettiği zaman, bu kişilere ait hesapların silineceği ve doğrudan Ulusal Çocuk İstismarı Merkezi’ne (NCMEC) bildirileceği açıklandı.

Bu uygulama Amerika’da başlayacak.

Sistem fotoğrafların, ABD Kaybolan ve İstismara Uğrayan Çocuklar Ulusal Merkezi (NCMEC) ve diğer çocuk güvenliği kuruluşları tarafından derlenen çocuk cinsel istismarı görsellerini bir veritabanıyla karşılaştırmasını yapacak.

Bu veritabanlarındaki görseller sayısal kodlara çevirilerek saklanıyor ve Apple cihazındaki görselle eşleştirilebiliyor.

Ebeveynlerin herhangi bir kötü amaç gütmeden çocuklarını banyo ve benzeri ortamlarda çektiği yarı çıplak fotoğrafların ise sistem tarafından “hedef dışı” kabul edileceği, bu yönüyle iPhone kullanıcılarının endişelenmesine gerek duymadığı bildirildi.

Bütün bu açıklamalar, bazı uzmanların kişisel bilgilerin mahremiyeti bakımından duyduğu endişeleri gidermiş değil.

ABD’deki Johns Hopkins Üniversitesi’nde güvenlik araştırmaları yapan Matthew Green, “Apple’ın uzun vadeli planları ne olursa olsun, bu sistemi kullanacaklarını açıklamakla çok net bir işaret vermiş oldular: Yasaklı içerikleri izlemek için kullanıcıların telefonlarına sistem yerleştirmek serbest olacak” diyor ve ekliyor:

“Bu konuda haklı çıkıp çıkmamalarının hiçbir önemi yok. Bu bir eşiğin aşılması demek ve hükümetler bunu herkesten talep edecek.”

Apple’ın bu uygulaması kimi kesimler tarafından çocuk istismarını önlemeye yönelik büyük bir adım niteliğinde görülürken kimi kesimlerde de masum insanların zarar görebileceği ve devletlerin daha çok veri isteyebileceğine yönelik düşünceler uyandırmakta.

Kaynakça:

cumhuriyet.com.tr

reuters.com

tr.euronews.com

indyturk.com

apple.com

[vc_row][vc_column][vc_cta h2=”” add_button=”bottom” btn_title=”TIKLAYIN” btn_style=”flat” btn_shape=”square” btn_color=”danger” css_animation=”fadeInLeft” btn_link=”url:https%3A%2F%2Fcyberartspro.com%2Fteklif-isteme-formu%2F||target:%20_blank|”]KVKK, ISO 27001, Bilgi ve İletişim Güvenliği Rehberi, ISO 27701, Bilgi Güvenliği, Siber Güvenlik ve Bilgi Teknolojileri konularında destek ve teklif almak için lütfen[/vc_cta][/vc_column][/vc_row]